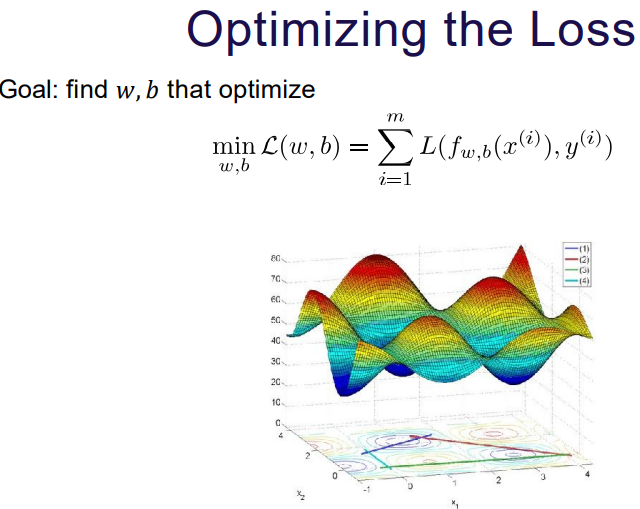

경사 하강법(gradient descent)에서 말하는 '경사'는 손실 함수(loss function)의 경사, 즉 기울기를 의미합니다. 여기서 손실 함수란 모델의 예측이 얼마나 잘못되었는지를 측정하는 함수로, 모델의 성능을 수치적으로 나타내줍니다.

경사(Gradient)의 의미

- 손실 함수의 기울기: 경사는 손실 함수의 각 파라미터(또는 가중치)에 대한 기울기를 나타냅니다. 이 기울기는 함수의 현재 지점에서 파라미터를 약간 변경할 때 손실 함수가 얼마나 변하는지를 나타내는 수치입니다.

- 방향과 크기: 경사는 벡터의 형태로, 각 파라미터에 대한 손실 함수의 변화율을 방향과 크기로 나타냅니다. 이 벡터는 손실을 가장 빠르게 증가시키는 방향을 가리키는데, 경사 하강법은 이와 반대 방향으로 파라미터를 업데이트합니다.

경사 하강법의 원리

- 반대 방향으로의 이동: 모델을 학습시킬 때, 경사 하강법은 손실 함수의 기울기를 계산하고, 이 기울기가 가리키는 방향의 반대로 파라미터를 조정합니다. 이 방향은 손실을 가장 빠르게 줄일 수 있는 방향입니다.

- 학습률(Learning Rate): 파라미터 업데이트 시 학습률이라는 값을 사용하여, 이동 거리(업데이트 크기)를 조절합니다. 학습률이 너무 크면 손실 함수의 최소값을 지나칠 수 있고, 너무 작으면 학습이 매우 느려질 수 있습니다.

- 최적화 과정: 이 과정을 반복하면서, 모델은 점차 손실 함수의 최소값에 도달하게 됩니다. 즉, 모델의 예측이 실제 데이터에 점점 더 가까워지는 것입니다.

결론적으로, '경사'는 손실 함수의 현재 지점에서의 기울기를 나타내며, 경사 하강법은 이 기울기의 반대 방향으로 파라미터를 조정함으로써 손실을 최소화하는 방식으로 작동합니다.

'MLDL_정리 > 용어, 메모장' 카테고리의 다른 글

| Graph Model - Transductive, Inductive (1) | 2023.10.29 |

|---|---|

| Conditioning (0) | 2023.10.29 |

| Self-supervised VS Transfer, Generative, Data Aug (0) | 2023.10.29 |

| Downstream Target Tasks (1) | 2023.10.29 |

| Mask RCNN ROI Align (0) | 2023.06.05 |